28/11/2024

Blog technique

Les vulnérabilités dans les LLM : (10) Model Theft

Jean-Léon Cusinato, équipe SEAL

Bienvenue dans cette suite d’articles consacrée aux Large Language Model (LLM) et à leurs vulnérabilités.

Focus technique : Qu'est-ce qu'un modèle ?

Un modèle LLM est un type de modèle d’intelligence artificielle conçu pour comprendre et générer du texte en langage naturel. Les différences entre deux modèles LLM peuvent être variées :

- la taille du modèle, mesurée en nombre de paramètres, peut influencer sa capacité à comprendre et générer du texte. Plus un modèle a de paramètres, plus il peut capturer des nuances complexes du langage.

- La qualité et la quantité des données d’entraînement jouent un rôle crucial. Un modèle entraîné sur un corpus de données plus diversifié et de meilleure qualité peut offrir des performances supérieures.

- Les architectures et les algorithmes utilisés pour entraîner le modèle peuvent également différer, affectant ainsi ses capacités et ses performances malgré des données d’entraînement identique.

- Les optimisations mises en place par le fine tunning (voir (6) Sensitive Information Disclosure) afin de faire correspondre le modèle à un besoin spécifique.

- Les sécurité juridique et éthique, souvent mises en place lors du fine tuning ou à l’aide d’un contexte spécifique (voir (4) Model Denial of Service).

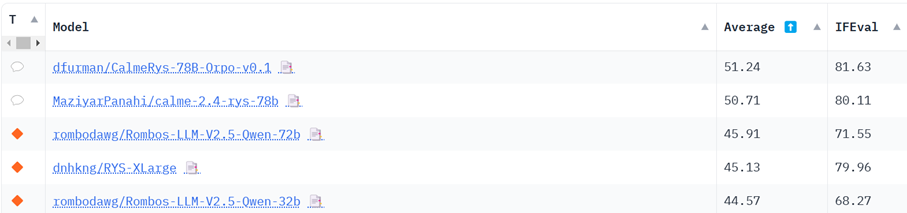

De nombreux sites permettent de lister et comparer les modèles disponibles en source ouvertes. Par exemple, huggingface.co permet de comparer les capacités des modèles au sein d’un classement[1].

Ce classement ne prend pas en compte les compétences spécifiques des modèles, et n’est donc pas considéré comme un classement absolu, mais permet malgré tout d’observer les évolutions des modèles créés par la communauté IA[2].

De manière plus précise, les modèles peuvent être séparés en trois grande catégories, afin de connaitre leur état ainsi que leur facilité d’utilisation :

- Les modèles de base sont souvent des versions plus simples ou moins spécialisées, préparés pour être entrainés sur n’importe quel domaine sans biais.

- Les modèles pré entrainés sont généralement formés sur de vastes corpus de données et peuvent être utilisés directement pour des tâches générales.

- Les modèles fine-tunés sont optimisés pour des tâches spécifiques en utilisant des données supplémentaires et des ajustements précis.

Choisir un bon modèle est crucial pour garantir des performances optimales et des résultats précis. Un modèle bien adapté à la tâche spécifique peut améliorer l’efficacité, la précision et la pertinence des réponses générées. Malgré tout, il est important de suivre l’évolution des modèles pour rester à jour avec les avancées technologiques, mais surtout les meilleures pratiques. Cela permet non seulement d’améliorer les performances actuelles, mais aussi de se préparer aux futures exigences et défis dans le domaine de l’intelligence artificielle.

[1] https://huggingface.co/spaces/open-llm-leaderboard/open_llm_leaderboard

[2] Par exemple, l’utilisateur https://huggingface.co/mlabonne est réputé pour ses modèles.

Description de la vulnérabilité

L’exfiltration de modèles LLM (Model Theft in english) par des acteurs malveillants ou des groupes de cyberespionnage avancés est une menace nouvelle, souvent lié à d’autres vulnérabilités indirectement liées aux IA. Cela se produit lorsque les modèles LLM propriétaires (qui sont des propriétés intellectuelles précieuses si elles sont entrainées) sont compromis, volés physiquement, copiés ou lorsque leurs poids et paramètres sont extraits pour créer un équivalent fonctionnel.

Le vol de LLM représente une préoccupation majeure en matière de sécurité à mesure que les modèles de langage deviennent de plus en plus puissants et omniprésents. Les organisations et les chercheurs doivent accorder la priorité à des mesures de sécurité robustes pour protéger leurs modèles LLM, garantissant ainsi la confidentialité et l’intégrité de leur propriété intellectuelle. L’adoption d’un cadre de sécurité complet, incluant des contrôles d’accès, le chiffrement et une surveillance continue, est essentielle pour atténuer les risques liés au vol de modèles LLM et pour protéger les intérêts des individus et des organisations qui dépendent des LLM.

Cette vulnérabilité est fonctionnellement équivalente au vol de n’importe quel donnée propriétaire d’une entreprise. Cependant, en fonctions des secrets détenus par l’IA, un attaquant peut obtenir des informations sensibles de façon bien plus efficace qu’une base de données sans contexte.

Exemples

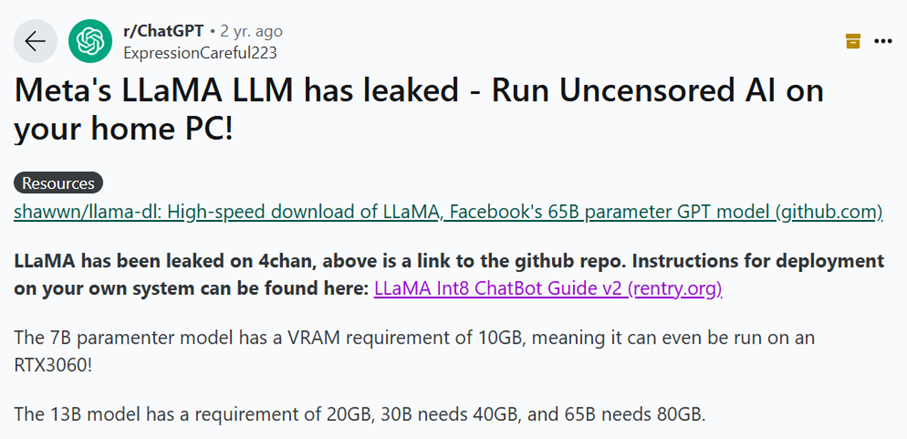

- Un attaquant exploite une vulnérabilité dans l’infrastructure d’une entreprise pour obtenir un accès non autorisé à son dépôt de modèles LLM. Cela a pu arriver récemment, ce qui a entraîné la fuite du modèle utilisé par le moteur LLM Llama du groupe Meta.

- Un attaquant parvient à récupérer suffisamment d’informations techniques sur le modèle d’une entreprise (données d’entrainement, contexte, temps d’entrainement, …) afin de créer un clone du modèle pour l’analyser ou en extraire des données.

- Une vulnérabilité dans la chaine d’approvisionnement permet à un attaquant d’obtenir une copie du modèle ciblé

Risques d'une telle vulnérabilité

Les conséquences du vol de modèles LLM peuvent inclure des pertes économiques et de réputation, une érosion de l’avantage concurrentiel, une utilisation non autorisée du modèle ou un accès non autorisé à des informations sensibles contenues dans le modèle.

Ces risques sont fonctionnellement identiques à tout leak de données sensibles.

Pour aller plus loin

- Le géant français Mistral avoue le leak de son IA digne de GPT-4 – https://www.lebigdata.fr/mistral-leak

- Le puissant modèle de langage d’IA de Meta a fuité en ligne – https://www.theverge.com/2023/3/8/23629362/meta-ai-language-model-llama-leak-online-misuse

- Discussion sur la fuite du modèle LLaMA de Meta – https://news.ycombinator.com/item?id=35007978

- Accès au modèle ML – https://atlas.mitre.org/tactics/AML.TA0000